Nagli razvoj veštačke inteligencije (AI) omogućio je čovečanstvu da „skoči“ u budućnost. Govori se o novoj tehnološkoj revoluciji, napretku i neslućenim promenama po ugledu na „industrijsku revoluciju“ ili pojavu interneta svojevremeno. Međutim, pre njenog vrhunca u razvoju, a čijeg stepena još nismo ni svesni, itekako nam se već sada ukazuju loše strane novih tehnologija i društvenih mreža. Spore državne birokratije još uvek nemaju adekvatan legalan nadzor i operativnost kako bi sprečile prevare i zloupotrebe a koje mogu da nanesu ogromnu finansijsku i psihološku štetu žrtvama nastalih usled korišćenja AI tehnologija.

Javne ličnosti našle su se prve na udaru kada su se društvenim mrežama munjevito širile njihove verno izmenjene fotografije, audio i video snimci. Lažne eksplicitne slike Tejlor Svift koje su osvanule na mreži X u januaru ove godine imale su preko 47 miliona pregleda pre uklanjanja. Armije vernih fanova uspele su da prijavama i žestokom reakcijom nateraju čelnike ove mreže da sklone sporne fotografije kao i da blokiraju pretragu. Veštački generisan lik Selene Gomez je reklamirao novi brend posuđa, a Internetom su se širile i lažne fotografije uhapšenog Donalda Trampa.

Međutim, nisu u opasnosti samo slavni i poznati. Pozivi vašeg roditelja ili deteta kom je hitno potreban novac, video poziv direktora koji traži da se novac firme prebaci na nepoznat račun, osvetnička pornografija ili lažne izjave političara samo su neki od načina zloupotrebe AI tehnologija koje stvaraju jednu novu realnost. Realnost u kojoj ne postoji poverenje u digitalni sadržaj na Internetu već lažne vesti i stalna sumnja u sve što se dešava.

Šta je „dipfejk“?

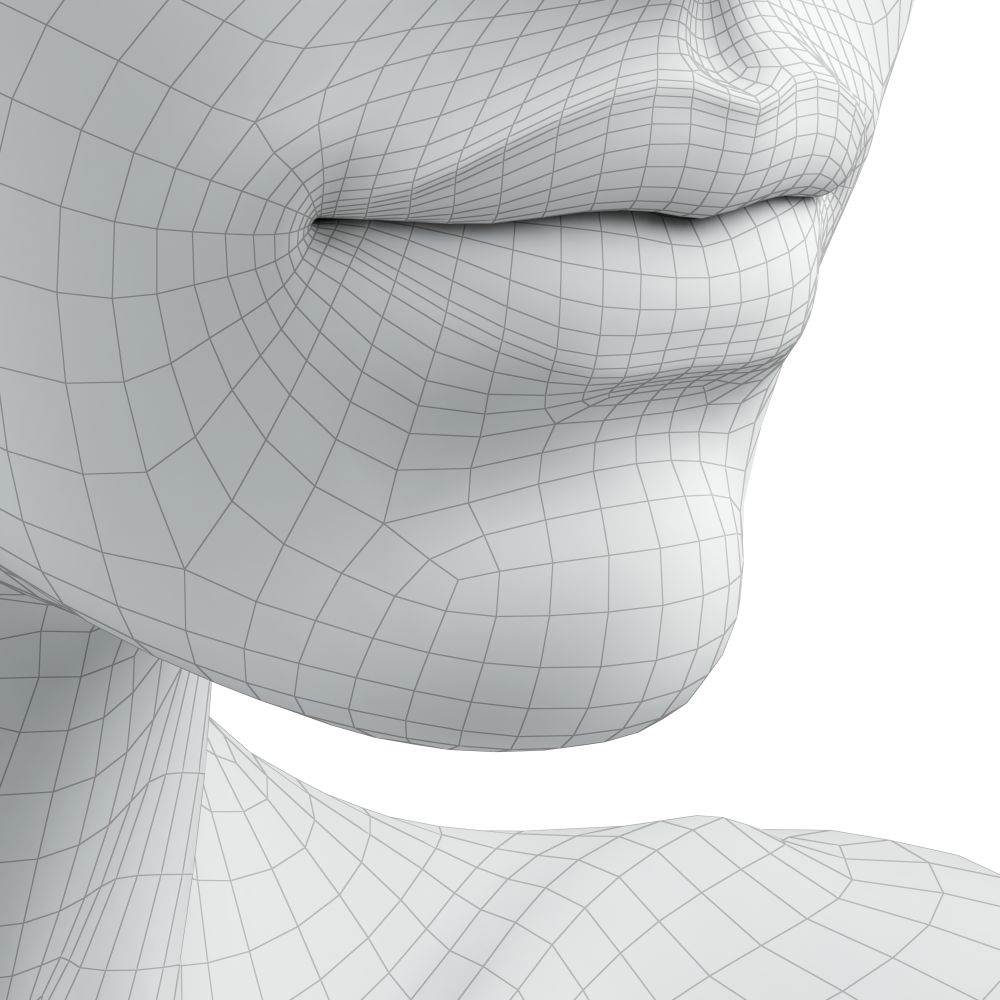

„Dipfejk“ se odnosi na sintetičke medije (fotografije, video zapise i audio snimke) kreirane korišćenjem veštačke inteligencije. U uobičajenim situacijama, stvarni podaci se manipulišu kako bi se kreirao izuzetno uverljiv sadržaj koji je veoma teško razlikovati od legitimnih medija. Na primer, lik osobe u postojećoj slici ili videu (uključujući lice i glas) zamenjuje se tuđim. Ovaj proces može stvoriti veoma ubedljive lažne video zapise i audio snimke koji izgledaju kao da prikazuju pojedince kako govore ili rade nešto što zapravo nikada nisu.

Razvoj alata za kreiranje glasa ili ilustracija (kao što su Chat GPT ili Dall-E) je skup i vremenski zahtevan, ali njihova upotreba je brza i jednostavna. Prema pisanju Los Anđeles tajmsa, tehnologija je napredovala do tačke gde je moguće napraviti „dipfejk“ video iz jedne jedine fotografije osobe, i “pristojan” klon glasa iz samo tri ili četiri sekunde audio zapisa. Međutim, alati koji su široko dostupni za pravljenje „dipfejkova“ zaostaju za najsavremenijim dostignućima i zahtevaju oko pet minuta audio snimka i jedan do dva sata video materijala.

Kako se mediji i digitalne platforme bore protiv „dipfejka“?

Poznati svetski mediji su odavno prepoznali problem lažnih vesti i već godinama ulažu resurse i sprovode metode proveravanja informacija ali i „dipfejk“ audio i video zapisa. Velike kompanije, kao što su „X“, „Google“, „Meta“, uspostavile su različite vrste mehanizama kao što su ustupanje podataka manipulisanih i nemanipulisanih video zapisa istraživačima. „X“ (ranije poznat kao „Tviter“) ima svoje protokole, koristeći set od četiri pravila za borbu protiv „dipfejka“: identifikacija putem obaveštenja u tvitovima, upozorenje o manipulisanom sadržaju pre deljenja, uključivanje linka ka autentičnim novinskim člancima koji objašnjavaju manipulaciju, i uklanjanje materijala koji potencijalno ugrožavaju sigurnost. „Meta“, uz pomoć organizacija za proveru informacija, ulaže maksimalne napore da ukloni lažni materijal sa svoje društvene mreže.

Da li je „dipfejk“ uvek loš?

Filmska industrija već duže vreme koristi veštački generisane vizuelne efekte kako bi obogatila filmsko iskustvo, ali potencijal „dipfejk“ tehnologije seže mnogo dalje, posebno u sferi obrazovanja. Mogućnost da učenici ne samo čitaju o Napoleonovim bitkama iz udžbenika, već da imaju priliku da “čuju” i vide Napoleona kako im lično priča o svojim strategijama i iskustvima mogao bi da dovede do bolje percepcije i zainteresovanosti za ovaj vid nastave. AI tehnologija može revolucionarno promeniti način na koji učimo o istoriji, umetnosti, nauci i drugim disciplinama, pretvarajući pasivno učenje u interaktivno iskustvo koje bi moglo dramatično poboljšati zadržavanje informacija kod učenika.

Kako se boriti protiv zloupotrebe „dipfejka“?

Najvažnije pravilo digitalne beznednosti jeste da treba biti oprezan pri deljenju sadržaja na internetu, ograničavanje pristupa fotografijama, videima i ostalim ličnim informacijama kako bi se očuvala privatnost. Takođe, upotreba vodenog žiga na fotografijama može odvratiti potencijalne zloupotrebljivače, budući da postoji mogućnost praćenja.

Edukacija igra vitalnu ulogu u prevenciji tako da redovno informisanje o najnovijim razvojima u AI tehnologijama omogućava prepoznavanje potencijalnih opasnosti. Na tržištu je dostupan velik broj aplikacija koje će vam omogućiti da putem telefona dodatno zaštitite šiframa svoje onlajn naloge kako biste imali još jedan sloj kontrole.

Korišćenje jakih, složenih šifri koje kombinuju simbole, brojeve i različita slova, zajedno sa redovnim ažuriranjem softvera, ključni su za održavanje visokog nivoa digitalne bezbednosti.

Osim toga, važno je održavati visok stepen opreza pri otvaranju novih mejlova, poruka ili primanju telefonskih poziva, posebno ako sadrže sumnjive zahteve ili hitne pozive za slanje novca.

Ukoliko naiđete na „dipfejk“ sadržaj koji uključuje vas ili nekoga koga poznajete, važno je brzo delovati i prijaviti taj sadržaj platformama i nadležnim institucijama. U slučajevima kada je reputacija ozbiljno ugrožena, razmislite o angažovanju pravnika specijalizovanog za digitalne pretnje i zloupotrebe.

Iako AI tehnologija vrlo brzo napreduje, napreduju i softveri za njeno prepoznavanje i zaštitu korisnika. Tako da koliko god da smo zaštićeni, treba obratiti pažnju na detalje video snimka ili fotografija, jer svaka nelogičnost (kao što je manjak prstiju) može ukazati da se radi o manipulisanim fotografijama. Takođe, ukoliko dobijete sumnjiv audio poziv, postavite dodatno pitanje kako biste bili sigurni da se radi o pravoj osobi a ne o lažnom predstavljanju koje želi da izvrši prevaru.

U svetu u kom tehnološke inovacije donose nesigurnost neophodno je zaštititi se jer smo često izloženi rizicima kojih nismo ni svesni. Važno je štititi svoj digitalni identitet, informacije i „osetljive“ objave kako ne bismo bili izloženi zloupotrebama.

Tekst: Ana Rajić

Foto: Shutterstock